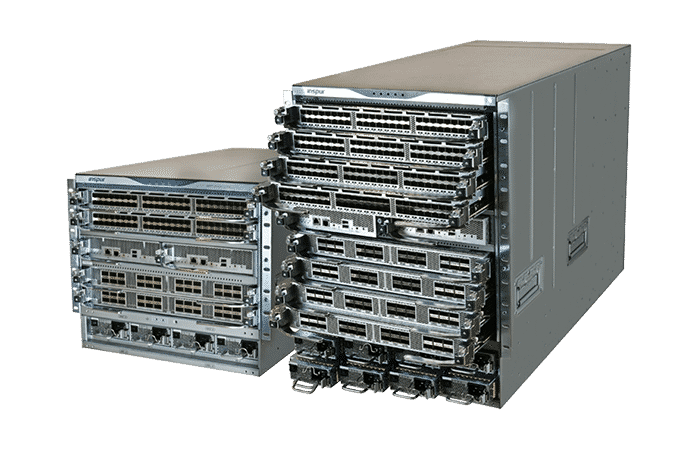

浪潮思科 CN12700 系列交换机

浪潮思科 CN12700 采用业界先进的 CLOS 架构,利用信元交换提供第 2 层和第 3 层的无阻塞转发。浪潮思科 CN12700 系列数据中心高性能交换机提供云数据中心 10G 和 40G 高密度接口板。优良的 VxLAN 功能实现分布式和集中式网关部署并且基于 BGP EPVN 实现 IP fabric 灵活组网架构、基于 Netconf、Openflow 协议的 SDN 控制器全局部署和集中化管理。高性能数据中心核心交换机旨在满足关键任务型数据中心的需求,该系列交换机可提供出色的可用性、卓越的可扩展性以及久经验证的全面的数据中心交换功能。采用可扩展的完全分布式交换架构, 高性能数据中心核心的中置背板设计支持随需求变化而进行灵活的升级,并提供持续的投资保护。未来的交换矩阵模块可使该平台获得更高的带宽能力。

基于高性能数据中心核心交换机先进的硬件结构和丰富的软件特性,可以构建高度扩展性的数据中心 ,实现多数据中心无障碍互联,使扩展网络简化管理,实现虚拟化感知的网络;通过虚拟化整合,实现I/O、链路、网络的高度融合,对云计算应用实现智能感知。

交换能力

CN12706 最高可达 258Tbps,CN12710 最高可达 380Tbps,整机三层包转发率: CN12706 最高可达 110.05Gpps,CN12710 最高可达 230.05Gpps。通过低于 5 微秒的延迟,使数据中心客户能够建立一个强大的网络交换矩阵,从而满足大型数据 中心部署的需求。

虚拟化I/O

新一代数据中心以太网协议 DCB (Data Center Bridge)有两个是与流控和服务质量保证相关的重要协议,包括 IEEE802.1qbb (Priority based flow control) 和 IEEEE802.1qaz (Cos based bandwidth management)。IEEE802.1qbb通过对流量的优先级进行分级,配合 pause 的反压机制,实现关键业务的不丢帧。IEEE802.1qaz 则可以给不同优先级的流量分配不同的带宽。另外 T11 通过 FC-BB-6 定义了 FC 帧在 DCB 网络上的承载方法,也就是 FCoE(FiberChannel over Ethernet),从本质上说,FCoE 是 DCB 所承载的应用之一。通过这些流控机制,我们可以保证存储相关的 FCoE 的流量在网络拥塞时不会发生丢帧,并被优先传送,从而保证响应时间。通过 DCB/FCoE 技术,我们可以将以往需要多张网承载的流量,整合到一张网也就是数据中心以太网上来承载,实现了网络上 I/O 的整合和虚拟化。

同时现有的 DCB/FCoE 技术已经非常成熟,交换机已经可以支持 VE 接口,也就意味着我们可以完全基于以太网实现传统 SAN 的核心-边缘的拓扑,做到流量的完全融合和虚拟化,数据中心内部也只有一张网也就是数据中心以太网。

交换机板卡延伸技术FEX (Fabric Extender)

新一代的数据中心核心交换机采用了板卡延伸技术,这一技术通过 IEEE802.1qbh 协议的实现,将原本的 TOR(Top of Rack) 机柜交换机)接入层交换机由核心交换机的独立交换板卡扩展器替换,实现接入层与核心层的控制平面和转发平面融合在一起,形成了多个交换机组合成一个交换机的状态,原有的分布在各个机架的 TOR 接入交换机就成为新交换机的远程板卡。在这个架构下,TOR 交换机不是单独存在的网元管理点,也不用二层的生成树或三层的路由协议来维护网络拓扑。现有技术已经可以将多达 64 个 TOR 交换单元的控制平面融合在一起,从而大大减少了网络节点,简化了网络拓扑,提高了网络的可管理性和可维护性。这一技术综合了 TOR 方式在布线上的优势和 EOR (End of Row) 方式管理节点少的两方面的优势。

支持大规模扩展网络技术(FEX+vPC)

传统的二层的网络,由于采用生成树协议,无法提供等价多路径 ECMP(Equal Cost multi-path,等价链路负载均衡计算)的能力,也就无法提供大规模计算集群无阻塞交互的带宽。所以数据中心通常采用三层交换机作为接入交换机,以利用三层的 ECMP 的支持能力。但这种模式把数据中心网络切分成了很多小块的二层网,在部署虚拟化应用时,有很大的局限性,因为很多的基于虚拟化的应用如 VMotion, LPAR Mobility 等都需要一个二层网络的支撑。因此新一代数据中心的网络需要在二层上来提供大规模的网络扩展能力。vPC(Virtual Port-Channel)是一种扩展技术,它通过将两个交换机的转发平面整合,实现接入设备采用 Port-Channel 同时上联技术,实现接入设备同时接入到两个汇聚交换机,可以通过配置跨框链路聚合,实现双倍的聚合带宽。采用独立交换板卡扩展器和 vPC 技术,可以有效扩展网络规模,同时减少生成树对于网络的影响。

虚拟交换机技术(vDC)

一个典型的新一代数据中心,无论是以云计算为架构的公有云,私有云,虚拟私有云建设,还是以技术领先的数据大集中型数据中心建设,它都具有典型的多用户多分区的特点。不同的用户的不同业务在同一套物理的系统上运行,这就要求在网络层面必须具有优异的隔离能力,只有实现了真正的安全隔离,我们才能够实现多种业务整合在同一个网络系统上。

传统的网络技术在多个层面实现了逻辑隔离,比如采用 VLAN/PVLAN/VSAN 等实现数据链路层的隔离,采用 VRF/VPN 实现网络层的安全隔离,但这些技术在实现时是基于同一个进程。

现在数据中心的核心交换机上又提供了更进一步的隔离技术,虚拟交换机 VDC (Virtual Device Context),通过虚拟交换机技术,一个交换机可以在逻辑上分为多个虚拟交换机,这些虚拟交换机之间是彻底隔离的,它们有各自独立的二层和三层的协议栈和进程,有各自独立的管理员,虚拟交换机之前是无法通过逻辑配置实现联通的。同时,由于它们的软件进程是完全独立的,当某个虚拟交换机的出现问题的时候,是不会影响到别的虚拟交换机,实现了完善的故障隔离。

通过虚拟交换机技术,我们设计把对安全要求高,原来必须运行在独立的网络里的业务运行在整合到统一的网络资源池上来运行,实现网络资源的灵活调度,以及数据安全和节能减排。

数据中心跨地域互联

通过 FabricPath 等技术,我们可以构建一个大规模的虚拟化数据中心网络。由于供电制冷的限制,容灾备份等要求,我们可以设计构建物理上分离但逻辑上一体的跨数据中心的网络,基于这个网络来建立分布式虚拟化的数据中心。通过这个网络,计算能力可以在不同的数据中心之间自由流动。我们只有把一个数据中心的网络通过技术延伸到远端的数据中心,才能实现这样的业务需求。OTV(Overlay Transport Virtualization)就是这样的一个技术,通过 OTV 技术可以实现穿越 IP 骨干的数据中心网络的打通。OTV 技术借用了一部分 EoMPLSoGRE 的数据帧封装,当采用了完全不同的控制平面。通过 ISIS 来建立 Adjacency 关系,并交换数据中心之间的 MAC 地址表。OTV 技术对于 IP 骨干网的要求只是 IP 可达,不需要 MPLS 的支持,大大简化了网络的维护。同时由于采用了控制平面和转发平面的分离,有效阻止了二层广播泛滥到 IP 骨干上,同时也不需要把生成树跨在数据中心间的骨干网上,大大提高了整个网络的稳定性。

通过 OTV 技术,我们可以通过 IP 网络实现多个数据中心的网络的整合和虚拟化,实现计算资源在不同数据中心间的自由流动,也为双活数据中心的实现提供了网络保证。